Arm技术助力Google Axion处理器加速AI工作负载推理

时间:2025-03-10 07:03:07 出处:探索阅读(143)

作者:Arm基础设施事业部高级产品经理 Ashok Bhat

由 Arm Neoverse V2 平台赋能的术助速 Google Axion 处理器已在 Google Cloud 上正式上线,其中,力G理C4A 是处理首款基于 Axion 的云虚拟机,为基于 CPU的器加人工智能(AI) 推理和通用云工作负载实现了显著的性能飞跃。

Axion CPU 延续了 Google Cloud 的作负载推定制芯片计划,旨在提高工作负载性能和能效,术助速标志着在重塑 AI 云计算格局方向上的力G理重大进步。Google 选择 Arm Neoverse 平台是处理因为它具备高性能、高能效和创新灵活性,器加而且有着强大的作负载推软件生态系统和广泛的行业应用,可确保与现有应用的术助速轻松集成。

Neoverse V2 平台引入了新的力G理硬件扩展,例如 SVE/SVE2、处理BF16 和 i8mm,器加与上代 Neoverse N1 相比,作负载推显著增强了机器学习性能。这些扩展增强了向量处理、BFloat16 运算和整数矩阵乘法,使得基于 Neoverse V2 的 CPU 每周期执行的 MAC 运算次数比 N1 提高最多四倍。

从生成式 AI 到计算机视觉:加快 AI 工作负载推理速度并提升性能

立足于开源为原则的 AI 具备众多领先的开源项目。近年来,Arm 一直与合作伙伴开展密切合作,以提高这些开源项目的性能。在许多情况下,我们会利用 Arm Kleidi 技术来提高 Neoverse 平台上的性能,Kleidi 技术可通过 Arm ComputeLibrary 和 KleidiAI 库访问。

大语言模型

由 Meta 开发的 Llama 模型包含一系列先进的大语言模型 (LLM),专为各种生成任务而设计,模型大小从 10 亿到 4,050 亿个参数不等。这些模型针对性能进行了优化,并可针对特定应用进行微调,因而在自然语言处理任务中用途广泛。

Llama.cpp 是一个 C++实现方案,可以在不同的硬件平台上实现这些模型的高效推理。它支持 Q4_0 量化方案,可将模型权重减少为 4 位整数。

为了展示基于 Arm 架构的服务器 CPU 在 LLM 推理方面的能力,Arm 软件团队和 Arm 合作伙伴对 llama.cpp 中的 int4 内核进行了优化,以利用这些新的指令。具体来说,我们增加了三种新的量化格式:为仅支持 Neon 的设备添加了 Q4_0_4_4,为支持 SVE/SVE2 和 i8mm 的设备添加了 Q4_0_4_8,为支持 SVE 256 位的设备添加了 Q4_0_8_8。

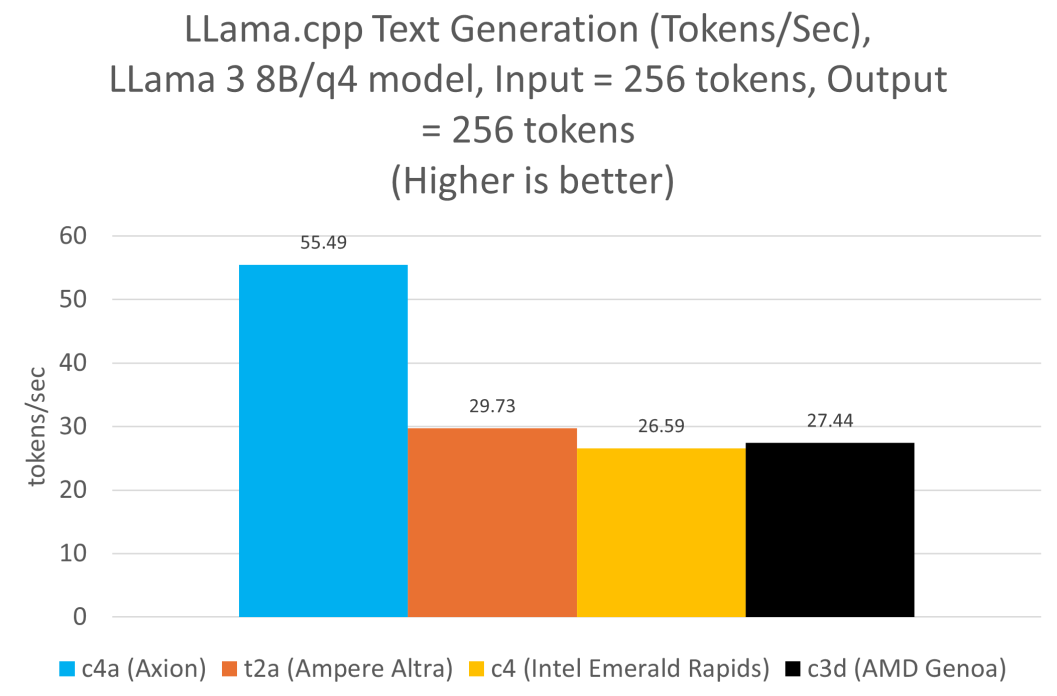

因此,与当前的 x86 架构实例相比,基于 Axion 的虚拟机在提示词处理和词元 (token) 生成方面的性能高出两倍。

我们在所有实例上运行了 Llama 3.1 8B 模型,并对每个实例使用了推荐的 4 位量化方案。Axion 的数据是在 c4a-standard-48 实例上使用 Q4_0_4_8 量化方案生成的,而 Ampere Altra 的数据是在 t2a-standard-48 实例上使用 Q4_0_4_4 生成的。x86 架构的数据是在 c4-standard-48 (IntelEmerald Rapids) 和 c3d-standard-60 (AMDGenoa) 上使用 Q4_0 量化格式生成的。在所有实例中,线程数始终设置为 48。

BERT

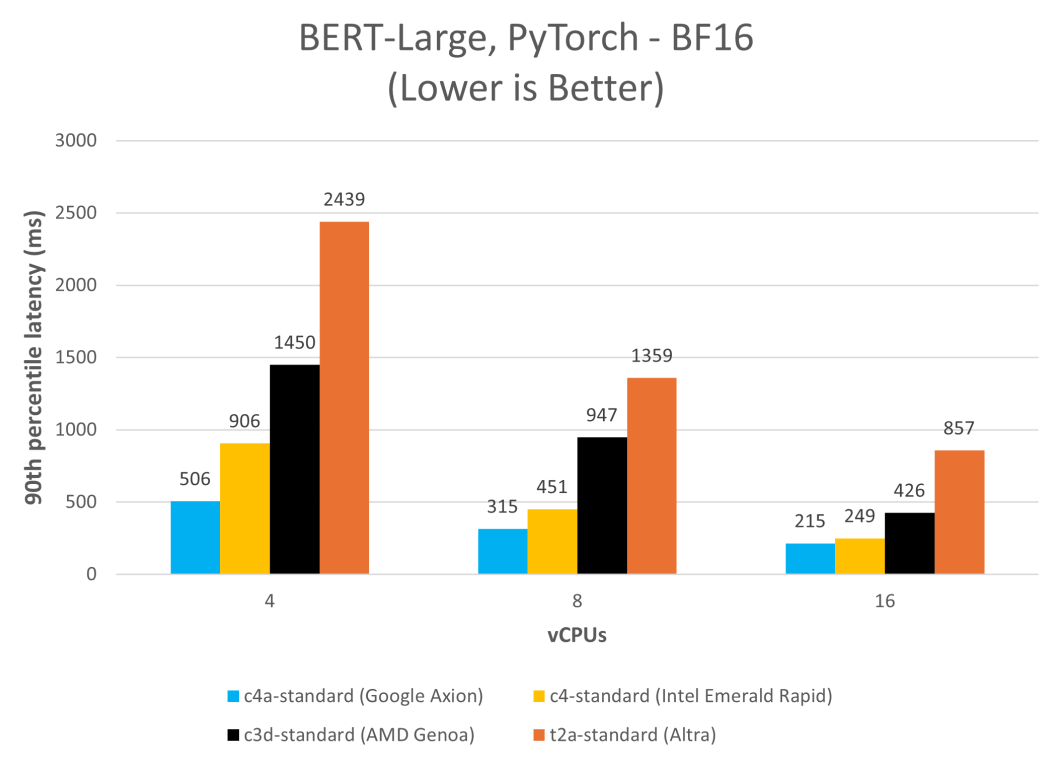

在 C4A 虚拟机上运行 BERT 取得了显著的速度提升,大幅减少了延迟并提高了吞吐量。此例中,我们在各种 Google Cloud 平台实例上以单流模式(批量大小为 1)使用 PyTorch 2.2.1 运行 MLPerfBERT 模型,并测量第 90 百分位的延迟。

ResNet-50

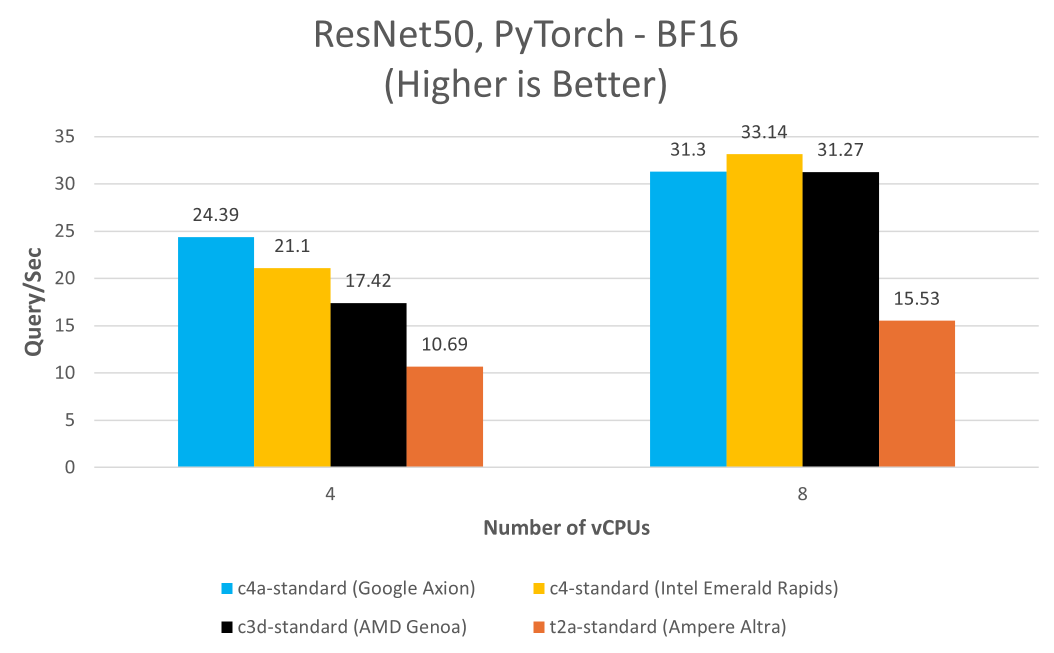

此外,Google Axion 的功能不仅限于 LLM,还可应用于图像识别模型,例如 ResNet-50 就能受益于此硬件的先进特性。BF16 和 i8mm 指令集成后,实现了更高的精度和更快的训练速度,展现了 Axion 相较基于 x86 架构实例的性能优势。

此例中,我们在各种 Google Cloud 平台实例上以单流模式(批量大小为 1)使用 PyTorch 2.2.1 运行 MLPerf ResNet-50 PyTorch 模型。

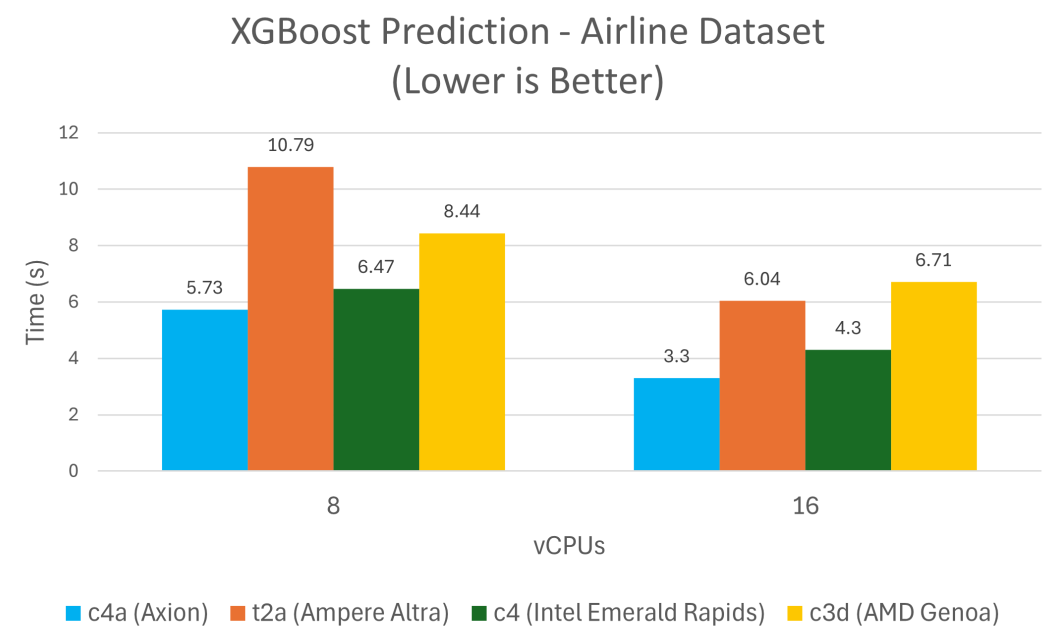

XGBoost

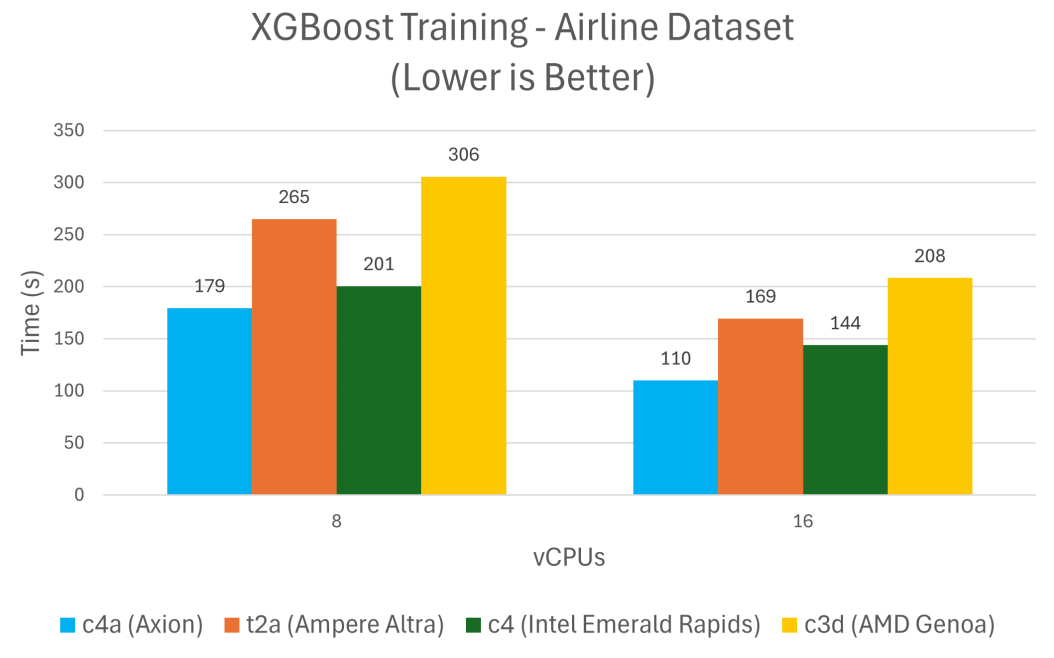

XGBoost 是一个领先的机器学习算法库,用于解决回归、分类和排序问题,与 Google Cloud 上类似的 x86 架构实例相比,在 Axion 上训练和预测所需的时间减少了 24% 到 48%。

结论

从上述结果,可以发现基于 Axion 的虚拟机在性能方面超越了上一代基于 Neoverse N1 的虚拟机和 Google Cloud 上其他的 x86 架构替代方案。Google Cloud C4A 虚拟机能够处理从 XGBoost 等传统机器学习任务到 Llama 等生成式 AI 应用的各类工作负载,是AI 推理的理想之选。

Arm 资源:助力云迁移

为了提升 Google Axion 的使用体验,Arm 汇集了各种资源:

[1] 通过 Arm Learning Paths 迁移到 Axion:依照详细的指南和最佳实践,简化向 Axion 实例的迁移。

[2] Arm Software Ecosystem Dashboard:获取有关 Arm 的最新软件支持信息。

[3] Arm 开发者中心:无论是刚接触 Arm 平台,还是正在寻找开发高性能软件解决方案的资源,Arm 开发者中心应有尽有,可以帮助开发者构建更卓越的软件,为数十亿设备提供丰富的体验。欢迎开发者在 Arm 不断壮大的全球开发者社区中,下载内容、交流学习和讨论。